O co chodzi z „pamięcią” modeli LLM i dlaczego to złudzenie

Jeśli korzystasz z ChatGPT, Bing AI, Gemini albo innego „inteligentnego” asystenta, prawdopodobnie masz wrażenie, że Twój rozmówca zapamiętuje wszystko: Twoje pytania, ulubiony styl odpowiedzi, fakty z poprzednich wątków. Wielu ludzi mówi wprost: „On wszystko pamięta!”, ale technicznie rzecz biorąc… to złudzenie.

Modele LLM (Large Language Models) nie mają wbudowanej trwałej pamięci tak, jak człowiek czy komputer z dyskiem. Nie zapisują „w głowie” całych rozmów ani nie budują bazy danych z każdą nową sesją. To, co nazywamy ich „pamięcią”, to sprytny trik, polegający na tym, że cała historia rozmowy jest za każdym razem wstrzykiwana razem z Twoim pytaniem, a model analizuje ją od nowa. Zrozumienie tego jest kluczowe, żeby wiedzieć, czego się po LLM spodziewać i jak z nimi mądrze rozmawiać.

Jak to działa? Czyli czym jest pamięć wątku.

Każda sesja czatu (nazywana wątkiem) działa jak notatnik, do którego dopisywane są Twoje pytania i odpowiedzi modelu. Gdy zadajesz kolejne pytanie, system wysyła do modelu Twój najnowszy prompt plus cały zapis rozmowy od początku — albo przynajmniej jego istotną część, mieszczącą się w tzw. oknie kontekstu.

Okno kontekstu to ograniczona liczba „tokenów” (czyli fragmentów tekstu) — w praktyce może to być kilka, kilkadziesiąt, a nawet ponad 100 tysięcy tokenów w najnowszych wersjach GPT-4. Im większe okno, tym więcej historii zmieści się „w głowie” modelu przy jednej odpowiedzi.

Ale uwaga: to nie jest pamięć trwała. To raczej tymczasowy bufor, który jest nadpisywany — stara historia może być usunięta, gdy zabraknie miejsca na nowe wiadomości. Dlatego jeśli rozmowa jest bardzo długa, model w końcu „zapomni” najstarsze fakty: po prostu zostaną one obcięte, bo limit tokenów został wyczerpany. To właśnie wtedy możesz zauważyć, że AI zaczyna się powtarzać, myli szczegóły albo zaprzecza temu, co sama wcześniej napisała.

Pamięć wątku, zależy od wybranego modelu. Poniżej zestawienie “pojemności” konkretnych modeli AI:

| Model | Data premiery | Maks. długość okna kontekstu (tokeny) | Przybliżona liczba słów |

|---|---|---|---|

| GPT‑4o | Maj 2024 | 128 000 | ~96 000 |

| GPT‑4-mini | Kwiecień 2025 | 200 000 | ~150 000 |

| GPT‑4-mini-high | Kwiecień 2025 | 200 000 | ~150 000 |

| GPT‑3.5-turbo | Marzec 2023 | 16 000 | ~12 000 |

| Gemini 2.5 Flash | Kwiecień 2025 | 1 000 000 | ~750 000 |

| Gemini 2.5 Pro | Marzec 2025 | 1 000 000 | ~750 000 |

| Claude 3.5 | Czerwiec 2024 | 200 000 | ~150 000 |

| Claude 3 Opus | Marzec 2024 | 200 000 | ~150 000 |

| Grok 1.5 | Marzec 2024 | 128 000 | ~96 000 |

Co się dzieje, gdy zmienisz model w trakcie rozmowy?

W ChatGPT i podobnych systemach możesz w trakcie rozmowy przełączyć się np. z GPT-3.5 na GPT-4, albo na wersję turbo. Technicznie: nowy model dostaje ten sam zapis rozmowy, co poprzedni. Problem w tym, że różne modele mają różne rozmiary okna kontekstu.

Przykład: GPT-3.5 może przetwarzać mniej tokenów niż GPT-4-turbo z rozszerzonym kontekstem. Gdy przełączysz model, a historia jest zbyt długa, nowy model nie dostanie całego wątku — system automatycznie obetnie najstarsze części, żeby zmieścić się w nowym limicie. Dlatego może nagle „zgubić” szczegóły, które wcześniejszy model jeszcze „pamiętał”.

Z tego powodu eksperci zalecają, żeby w jednej sesji trzymać się jednego modelu — albo jeśli musisz zmienić model, zastosuj sprytne techniki:

- Poproś obecny model o streszczenie rozmowy — np. „Podsumuj dotychczasowe ustalenia w 10 punktach”. Potem wklej to podsumowanie do nowego modelu jako wprowadzenie.

- Nie zmieniaj na model z mniejszą pojemnością okna kontekstu — unikniesz sytuacji w której tylko z powodu zmiany modelu “wyleci” z pamięci istotna dla Ciebie cześć Informacji

- Zewnętrzna pamięć — w dużych projektach możesz trzymać istotne informacje w pliku lub bazie wektorowej (technika Retrieval-Augmented Generation, czyli RAG). Model nie musi wtedy „dźwigać” wszystkiego w kontekście, bo kluczowe dane są pobierane dynamicznie.

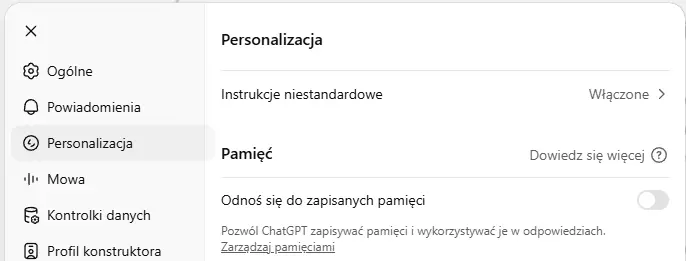

Czy włączona pamięć jest zawsze dobra? Zalety i pułapki

Plusy:

- Model szybciej „kojarzy” Twoje preferencje.

- Nie musisz w kółko pisać tego samego — styl odpowiedzi, forma grzecznościowa, Twoje ulubione tematy są uwzględniane automatycznie.

- Dłuższe projekty (np. seria artykułów) mogą być spójniejsze stylistycznie.

Minusy:

- Pamięć może mieszać wątki — np. styl poważny z artykułów przenika do luźnych rozmów.

- Im więcej faktów zapiszesz, tym więcej promptu zajmuje techniczna „metapamięć” — to zjada część okna kontekstu.

- Model może błędnie interpretować zapamiętane fakty, jeśli coś się u Ciebie zmieniło (np. zmiana pracy, miejsca zamieszkania).

- Pamięć nie zawsze aktualizuje się automatycznie — czasem warto ręcznie skasować stare fakty, by uniknąć pomyłek.

Podsumowanie

LLM nie mają magicznej pamięci. To, co widzisz w czacie, to sprytnie zbudowany system: Twoja historia jest wstrzykiwana do modelu, a on generuje odpowiedź na podstawie tego, co ma w promptcie. Funkcja pamięci (Memory) pomaga w personalizacji, ale też wprowadza nowe pułapki: może zamieszać style, zajmuje część kontekstu i czasem „wie” o Tobie więcej, niż byś chciał.

Dobra praktyka? Zarządzaj pamięcią świadomie, miej świadomość, jak działa okno kontekstu i bądź gotów przypomnieć modelowi najważniejsze fakty, gdy rozmowa się rozciąga.

Jeśli chcesz, żeby Twoje LLM naprawdę „pamiętało”, użyj dedykowanego systemu z RAG — tam wiedza jest w zewnętrznej bazie i zawsze da się ją zweryfikować.