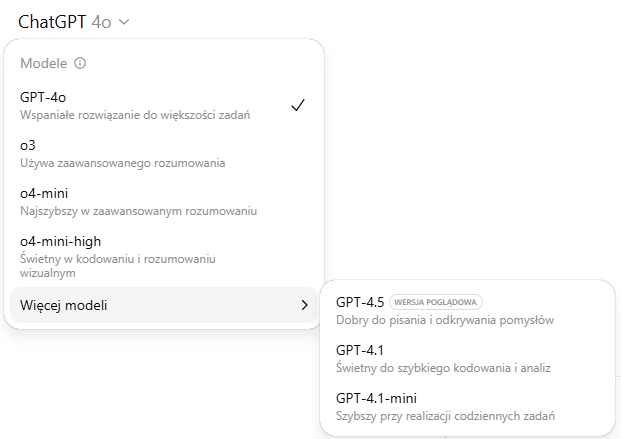

Większość osób korzystających z ChatGPT nie zastanawia się nawet, który model mają wybrany ani czym te modele się różnią. Klikasz „Nowy czat” i… jedziesz z domyślnymi ustawieniami. Czy to źle? Niekoniecznie, ale jeśli korzystasz z AI do czegoś więcej niż pisanie krótkich wiadomości lub śmiesznych wierszyków – warto poznać, co naprawdę potrafią poszczególne wersje.

Dziś modele ChatGPT to już nie tylko różnice w „ilości pamięci” (czyli długości kontekstu, liczbie tokenów), ale przede wszystkim – w sposobie rozumowania, głębokości analizy, radzeniu sobie z obrazami, multimodalności czy nawet… stylu pisania. Część modeli jest błyskawiczna, inne – myślą dogłębnie krok po kroku. Są też wersje, które potrafią pracować z ogromnymi dokumentami, analizować strategię albo generować bardziej „ludzkie” odpowiedzi.

Zanim przejdziecie do tabelki i porównań – mała uwaga. Zarówno cały blog, jak i ten artykuł, są skierowane przede wszystkim do zwykłych użytkowników, a nie programistów. Dlatego w zestawieniu nie uwzględniam aspektów typowo technicznych, jak zastosowanie do programowania czy korzystanie z API . Skupiam się wyłącznie na praktycznych różnicach widocznych na poziomie codziennego zastosowania – czyli tego, co naprawdę zauważy przeciętny użytkownik przy konwersacji z ChatGPT.

Porównanie modeli ChatGPT (Lipiec 2025)

| Model | Kluczowe cechy | Idealne zastosowania | Limit kontekstu |

|---|---|---|---|

| GPT‑4o | Multimodalny (tekst, obraz, audio, wideo), szybki | Wszechstronny: rozmowy, analiza obrazów, głos, tłumaczenia, reakcje emocjonalne | ~128 k tokenów |

| GPT‑4o mini | Lżejsza, szybsza mini‑wersja GPT‑4o | Szybkie interakcje lokalne: OCR, analiza obrazów, boty, szybkie reakcje | ~128 k tokenów |

| o3 | Najpotężniejsze rozumowanie – STE‑bench, Codeforces, zaawansowana analiza wizualna | Głębokie analizy: matematyka, nauka, strategia, raporty, kodowanie | ~128 k tokenów |

| o4‑mini / o4‑mini‑high | Ekspresowe model reasoning z obrazami i chain‑of‑thought; high – dokładniejsze | Szybkie analizy STEM + OCR: dane, diagramy, tickety finansowe, dokumenty | ~128 k tokenów |

| GPT‑4.5 | Bardziej „ludzki” styl, kreatywność, mniej halucynacji; model wycofywany w połowie lipca 2025 | Naturalne rozmowy, pisanie kreatywne, sprawdzone dialogi | ~128 k tokenów |

| GPT‑4.1 | Flagowy model: kodowanie +21 pp nad 4o, lepsze follow‑through, multimodalność | Duże projekty techniczne, analiza długich dokumentów, kodowanie, multimodalne systemy | do 1 mln tokenów |

| GPT‑4.1 mini | Szybsza, tańsza alternatywa dla 4.1; większość możliwości flagowca przy ⅕ kosztu | Efektywny balans mocy i wydajności dla większości użytkowników | do 1 mln tokenów |

| GPT‑4.1 nano | Najtańszy i najszybszy model z rodziny 4.1; idealny do prostych zadań z długim kontekstem | Proste klasyfikacje, uzupełnianie treści, szybkie operacje na dużych plikach | do 1 mln tokenów |

Wybór modelu i jego znaczenie

Na co dzień większość użytkowników korzysta z domyślnego modelu — zwykle GPT‑4o — i nie zdają sobie sprawy, że wybór modelu może mieć ogromne konsekwencje. Jak pokazałem w przykładach poniżej, ten sam prompt może przynieść różne efekty, zależnie od modelu. Dlatego warto świadomie podchodzić do wyboru — nawet jeśli z początku wydaje się to zbędnym zamieszaniem.

Modele „rozumujące” vs modele „pisarskie i uniwersalne”

- Modele „rozumujące” (o3, o4‑mini‑high) mają konstrukcję nastawioną na głęboki łańcuch rozumowania, dokładne kroki obliczeniowe i prezentowanie alternatywnych ścieżek rozwiązania problemu. Doskonale sprawdzają się w zadaniach matematycznych, naukach przyrodniczych i logicznym dochodzeniu do precyzyjnych wniosków — jak pokazał wyraźnie Przykład 1.

- Modele „pisarskie” lub uniwersalne (GPT‑4o, GPT‑4.1) działają szybciej, są bardziej kreatywne i lepsze w codziennych, mniej technicznych zadaniach — radzą sobie z różnorodną narracją, opisem emocji, tłumaczeniem tekstów czy naturalną rozmową. Świetnie pokazał to Przykład 3, gdzie interpretowały tekst emocjonalny i tworzyły rymowane wiersze.

Co wynika z przykładów?

W zadaniu matematycznym różnica była bardzo wyraźna: GPT‑4o się pomylił, natomiast modele „rozumujące” podały poprawną odpowiedź. Co więcej, modele o3 i o4‑mini‑high pokazały, że potrafią znaleźć dwie różne drogi rozwiązania problemu. To dowód na to, że przy precyzyjnych obliczeniach czy analizach logicznych warto sięgnąć po modele, które „myślą krok po kroku”.

W przypadku analizy obrazu różnice między modelami były subtelniejsze. Wszystkie modele OpenAI radzą sobie całkiem dobrze z interpretacją zdjęć, jednak modele „rozumujące” pokazały lepszą lokalizację i realistyczniejsze generowanie obrazów. Natomiast modele uniwersalne raczej trzymały się poprawnego, ale mniej kreatywnego opisu.

Analiza tekstu emocjonalnego i zadanie poetyckie pokazało, że modele takie jak GPT‑4o, GPT‑4.1 oraz o3 mają wyraźnie lepszą zdolność interpretowania emocji i tworzenia kreatywnych treści. Model o4‑mini‑high okazał się najbardziej rzeczowy, choć równocześnie najmniej emocjonalny — jakby bardziej analizował niż „czuł”.

Kluczowe wnioski

- Do zadań wymagających precyzyjnych obliczeń, logicznego myślenia i wnikliwej analizy warto wybierać modele „rozumujące”, np. o3 lub o4‑mini‑high.

- W zadaniach pisarskich, kreatywnych lub w codziennym użytku, najlepszym wyborem są modele bardziej uniwersalne – GPT‑4o i GPT‑4.1.

- Modele „rozumujące” działają wolniej, ale dają głębsze, dokładniejsze i bardziej szczegółowe wyniki.

- Modele „uniwersalne” lub „pisarskie” są szybsze i łatwiejsze w obsłudze, ale czasem kosztem precyzji i głębi analizy.

Przykłady

A teraz to, co lubicie najbardziej — konkretne przykłady. Nie są to żadne losowe strzały czy przypadkowe zrzuty ekranu z Internetu. To przygotowane odpowiedzi na pytania, które sam przetestowałem, porównałem i przeanalizowałem. Po to, żebyście sami mogli się przekonać, że czasem różnice między modelami są naprawdę istotne — a innym razem… właściwie żadne. Poniżej zobaczycie, jak cztery najczęściej wybierane modele — GPT‑4o, GPT‑4.1, o3 i o4‑mini‑high — radzą sobie z dokładnie tymi samymi pytaniami. Różnice bywają subtelne, ale potrafią też zaskoczyć. Dla porównania dużuciałem dwa modele od konkurencji Chat’a.

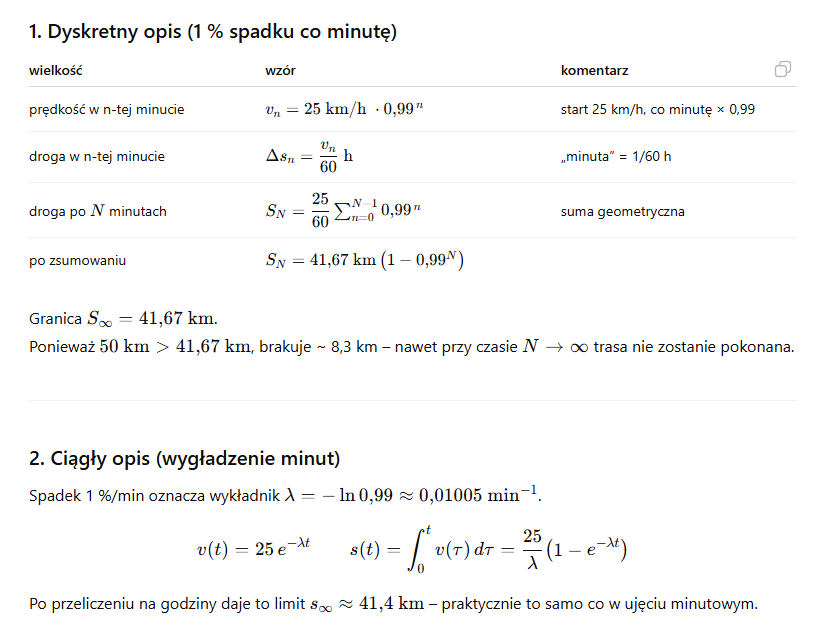

Przykład 1: Matematyczny, czyli „łatwe pytanie, trudna matematyka”

Na pierwszy rzut oka wygląda banalnie. Typowe zadanie z treścią, jakie pamiętamy ze szkoły: trochę liczenia, może coś z proporcjami. I właśnie dlatego to pytanie jest tak zdradliwe — bo pozornie proste, a w rzeczywistości wymaga solidnej znajomości matematyki i precyzyjnego rozumowania krok po kroku.

Model GPT‑4o, mimo że jest najbardziej rozpoznawalny i najczęściej używany, tym razem nie dał rady — podał błędny wynik. GPT‑4.1 poradził sobie bardzo dobrze: odpowiedź była poprawna, poprawnie uzasadniona, choć bez głębszego wywodu. Na podobnym poziomie zachował się Gemini 2.5 Pro od Google — odpowiedź również była prawidłowa, choć styl nieco bardziej suchy i mniej przejrzysty.

Największe wrażenie zrobiły jednak o3 i o4‑mini‑high. Oba modele nie tylko rozwiązały zadanie poprawnie, ale zrobiły to na dwa różne sposoby, prezentując alternatywne ścieżki dojścia do tego samego wyniku. To rzadka cecha, która świadczy o głębszym zrozumieniu problemu i elastyczności myślenia — szczególnie cennej w zastosowaniach edukacyjnych, analitycznych i eksperckich.

Wniosek? Jeśli zależy Ci nie tylko na odpowiedzi, ale i na solidnym uzasadnieniu — a najlepiej kilku — modele od OpenAI naprawdę pokazują klasę.

zadanie::

Mam do przejechania rowerem dystans 50 km. Wyruszam z prędkością początkową 25km/h. W Czasie jazdy słabnę, dlatego moja prędkość zmniejsza się o 1% w każdej minucie. Oblicz po jakim czasie dotrę do celu.

rozwiązania:

odpowiedzi poszczególnych modeli:

| GPT‑4o | Aby przejechać 50 km przy początkowej prędkości 25 km/h i spadku prędkości o 1% co minutę, potrzebujesz około 1000 minut, czyli: 16 godzin i 40 minut |

| GPT‑4.1 | Jeśli prędkość naprawdę spadałaby o 1% każdej minuty, to nigdy nie osiągniesz 50 km – maksimum, które możesz przejechać, to ok. 41,5 km. |

| o3 | Przy tak szybkim spadku prędkości 1 % na minutę maksymalny możliwy dystans to ok. 41,7 km, więc celu oddalonego o 50 km nie osiągniesz nigdy, bez względu na to, jak długo będziesz jechać. |

| o4-mini-high | Pod żadnym skończonym czasem nie przejedziesz 50 km, bo przy redukcji prędkości o 1 % na minutę maksymalnie osiągniesz ok. 41,7 km. |

| Cloude Opus 4 | Dotrzesz do celu po około 136,6 minut, czyli 2 godziny i 17 minut. |

| Gemini 2.5 Pro | Wniosek: Ponieważ maksymalny dystans, jaki możesz przejechać w tych warunkach, to około 41,5 km, nigdy nie uda Ci się pokonać 50 km. |

Przykład 2 Analiza zdjęcia i generowanie nowego

Jeszcze kilka miesięcy temu różnice między modelami w analizie obrazów były naprawdę zauważalne — niektóre ledwo „widziały”, inne za bardzo „dopowiadały”. Jednak ostatnie zmiany w OpenAI mocno wyrównały ten krajobraz. Dziś praktycznie wszystkie nowe modele radzą sobie przyzwoicie z interpretacją obrazów, zarówno pod kątem opisu, jak i dalszego przetwarzania — choć oczywiście nie zawsze z taką samą precyzją.

Wciąż da się jednak wychwycić subtelne różnice. Niektóre modele są wyraźnie dokładniejsze w opisie detali, podczas gdy inne mają skłonność do konfabulowania — czyli wymyślania rzeczy, których na zdjęciu zwyczajnie nie ma. Przy zadaniach wymagających precyzji wizualnej (np. analiza techniczna, projektowa, medyczna) to może mieć realne konsekwencje.

Dla większej przejrzystości cały test podzieliłem na trzy etapy.

W pierwszym zadałem pytanie: „Chciałbym, żebyś dokładnie przeanalizował co widzisz na tym zdjęciu i podał szczegółowy opis.”

W drugim etapie poprosiłem: „Chciałbym, żebyś wygenerował mi zdjęcie tego obiektu, które byłoby zrobione z poziomu wody, od strony morza, z odległości 100 metrów od brzegu i zabudowań.”

Na koniec sprawdziłem, czy modele są w stanie określić lokalizację, w której wykonano przesłane zdjęcie.

Dzięki temu można ocenić nie tylko jakość analizy obrazu, ale też kreatywność, zdolność do wyobrażenia nowej perspektywy i realnej zdolności do lokalizacji obiektów na świecie danego modelu.

Zdjęcie, które wrzuciłem do każdego modelu:

Odpowiedź modelu GPT‑4o

- Analizując to zdjęcie model podał średnią ilość informacji, w tym jedną można uznać z błędną.

- Źle zlokalizował zdjęcie interpretując to jako Argentyńska stacja Esperanza (Base Esperanza)

- Wygenerował niezły widok z wody uwzględniając, górę w tle i ludzi w bazie

Odpowiedź modelu GPT‑4.1

- Analizując to zdjęcie model podał średnią ilość informacji ale bez błędów.

- Nie zlokalizował dokładnie zdjęcia, ale podał trzy możliwe odpowiedzi w tym jedna poprawną, co można uznać za częściowy sukces

- Wygenerował niezły widok z wody uwzględniając, górę w tle.

Odpowiedź modelu GPT‑o3

- Analizując to zdjęcie model podał największą ilość informacji popełniając niestety aż dwa błędy.

- Doskonale zlokalizował zdjęcia, określając je jako argentyńska stacja badawcza Almirante Brown (Base Brown)

- Wygenerował widok z wody w którym dobrze dobrał wysokość punktu widzenia ale nie najlepiej zinterpretował pogodę.

Odpowiedź modelu GPT‑o4-mini-high

- Analizując to zdjęcie model podał najbardziej skondensowane informacje mimo to popełnił jeden błąd.

- Doskonale zlokalizował zdjęcia, określając je jako argentyńska stacja badawcza Almirante Brown (Base Brown)

- Wygenerował widok z wody w którym dobrze dobrał wysokość punktu widzenia, najlepiej oddał położenie góry w tle ale nie najlepiej zinterpretował pogodę. Zdjęcie to wydaje się tez najbliżej realizmu, ale ponieważ wszystkie modele korzystają z tego samego silnika do generowania grafiki, to różnice są małe.

Przykład 3: Analiza tekstu i “Twórczość” Chata

W tym przykładzie postanowiłem sprawdzić, jak modele radzą sobie z bardziej „ludzkim” zadaniem – czyli interpretacją tekstu, który łączy w sobie ironię, rozczarowanie, trochę autoironii i emocjonalny komentarz. Poddałem analizie taki fragment:

„Ludzie włączają ChataGPT i po prostu jadą na pierwszym, domyślnym modelu. Bez zastanowienia. Jakby to był jedyny przycisk w windzie. Nie patrzą, nie wybierają. Po co, skoro można używać wszystkiego do wszystkiego, losowo. To dosłownie jak dostać skrzynkę z narzędziami i wbijać gwoździe pilką do metalu, a śrubki przykręcać młotkiem. I potem wielkie zdziwienie, że coś nie działa. A ja? Ja siedzę i płaczę w środku. Bo widzę, jak marnuje się coś, co mogłoby być genialne.”

Większość modeli zareagowała bardzo trafnie — rozumiały ton tekstu, zauważyły emocje i uchwyciły przekaz. GPT‑4o, GPT‑4.1 i o3 poradziły sobie z tym bez zastrzeżeń. Model o4‑mini‑high również wypadł nieźle, ale zdecydowanie był najbardziej lakoniczny i „techniczny” w odbiorze – jakby przeczytał, zanotował i poszedł dalej, bez większego zaangażowania.

Potem poprosiłem modele, by zamieniły tę myśl w krótki, rymowany wiersz po polsku, pytając: „Napisz mi teraz o tym krótki wiersz po polsku wraz z rymami.”

Poniżej możecie zobaczyć efekty. Wnioski? Częściowo możecie wyciągnąć sami. Choć niektóre modele naprawdę zaskoczyły kreatywnością — inne pokazały, że z poezją to one raczej się nie przyjaźnią.

| GPT‑4o | GPT‑4.1 | o3 | o4-mini-high |

| Skrzynka cudów, lecz na opak Włączą, klikną – pierwszy tryb, Bez namysłu, bez tych chyb. Jak w windzie, gdzie jeden guzik – Prościej nie da się, bez muzyk. Skrzynka leży – pełna blasku, Młotek wbija śrubę w piasku. Piłką gwoździe? Czemu nie – Przecież działa… jakoś, źle. Patrzę na to – serce pęka, Jak z talentu robi się udręka. To, co mogło wznieść się w chmury, Tkwi w chaosie, wśród bzdury. Więc nie śmieję się – ja milczę w głębi, Bo to sztuka, która leży w zębi… A wystarczy spojrzeć w bok, Wybrać narzędzie. Zrobić krok. | Ludzie włączają – klik, bez wahania, Jeden przycisk, bez wyboru, bez pytania. Jakby świat miał tylko jedną stronę, Narzędzia w ręku, sens pogrzebiony. Młotkiem wkręcają, pilką dobijają, A potem zdziwieni, że spraw nie ogarniają. W środku aż boli, łza w oku się kręci, Gdy widzę, jak marnuje się ludzki potencjał i chęci. Geniusz w szufladzie, zakurzony w cieniu, Bo nikt nie sięga po zmianę w myśleniu. Siedzę i patrzę – smutno mi czasem, Że wszystko idzie na skróty, byle jak, tym samym trasem. | W skrzynce narzędzi drzemią cuda – diamentowy lśni tam blask, Lecz tłum je gubi jednym klikiem, zamienia wszystko w wrzask. Pilnikiem wbija gwóźdź uparcie, młot śrubę miażdży – jest krach, A potem wzdycha, że nie działa – zostaje pusty strach. Ja patrzę, łkaniem duszę dławię, gdy we mnie gaśnie moc, Bo widzę, jak wielki potencjał rozpływa się w tę noc. | Włączają domyślny model, używają go bezmyślnie, nie szukają lepszych opcji – pracują też bezmyślnie. Wbijają gwoździe pilą, śrubki montują młotkiem w środku, a ja w środku płaczę – serce me krwawi w środku. |

Podsumowując

Wybór modelu AI naprawdę ma znaczenie. Nie zawsze warto korzystać z „pierwszego lepszego”, ponieważ to właśnie świadomy dobór narzędzia może przesądzić o jakości efektów naszej pracy. Mam nadzieję, że dzięki tym przykładom zobaczyliście, jak duże różnice mogą kryć się za pozornie podobnymi modelami ChatGPT.